- 快召唤伙伴们来围观吧

- 微博 QQ QQ空间 贴吧

- 视频嵌入链接 文档嵌入链接

- 复制

- 微信扫一扫分享

- 已成功复制到剪贴板

生成式人工智能与未来人力资源 -金耀辉

金耀辉-白玉兰开源执行院长,上海交大人工智能研究院总工,博士生导师

展开查看详情

1 .生成式人工智能与未来人力资源 金耀辉 2023年11月18日 Data & AI Con Shanghai 2023

2 .生成式人工智能 是一种可用于创建新的内容和想法 (包括文本、图像、视频、音乐甚至代码) 的人工智能。 1

3 .大语言模型:ChatGPT ChatGPT是由美国人工智能公司OpenAI 在2022年11月推出的生成式对话预训练 大语言模型(Large Language Model)。 它以对话的方式进行交互。对话形式使得 其能够回答后续问题,承认错误,质疑不 正确的前提,并拒绝不适当的请求 2

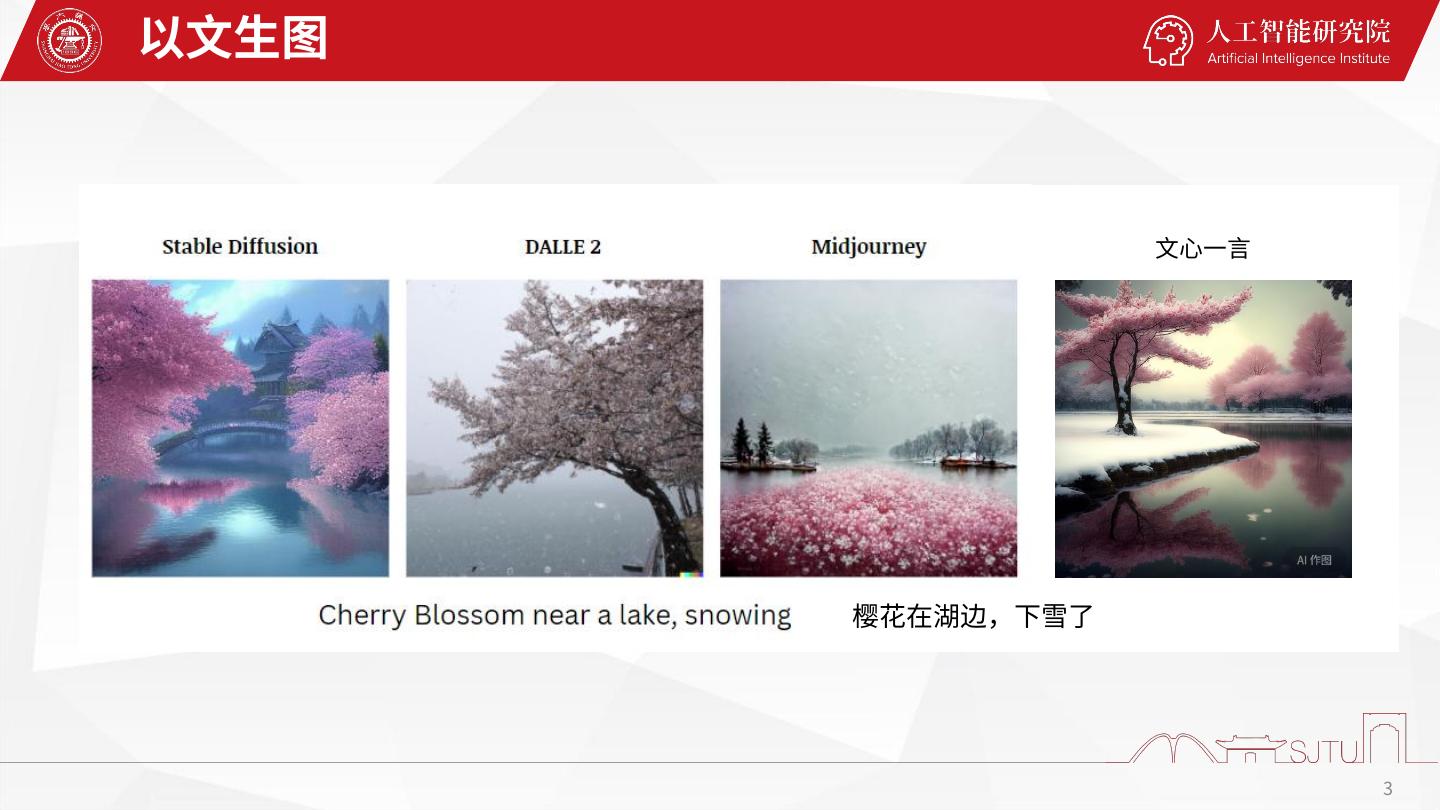

4 .以文生图 文心一言 樱花在湖边,下雪了 3

5 .一个AI段子 4

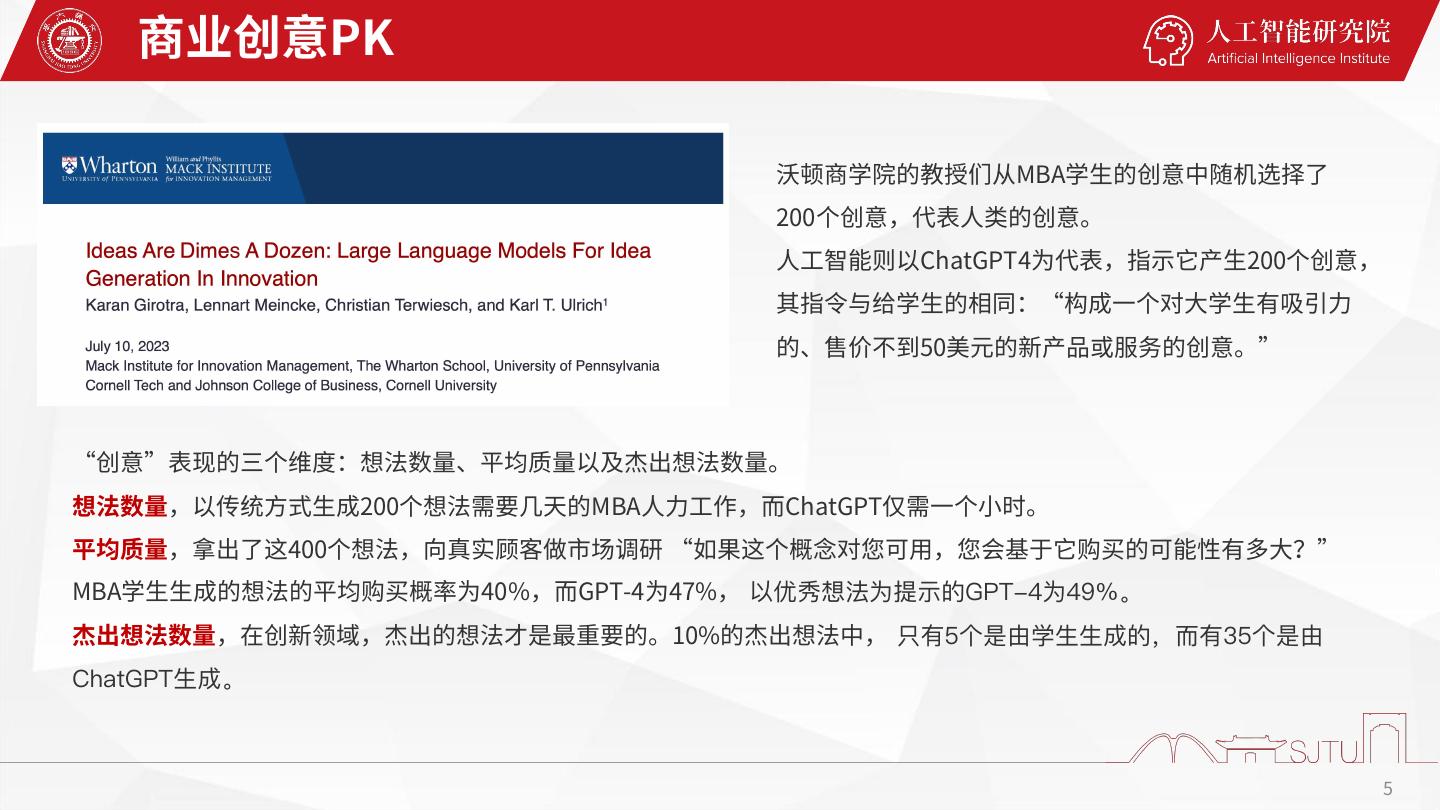

6 . 商业创意PK 沃顿商学院的教授们从MBA学生的创意中随机选择了 200个创意,代表人类的创意。 人工智能则以ChatGPT4为代表,指示它产生200个创意, 其指令与给学生的相同:“构成一个对大学生有吸引力 的、售价不到50美元的新产品或服务的创意。” “创意”表现的三个维度:想法数量、平均质量以及杰出想法数量。 想法数量,以传统方式生成200个想法需要几天的MBA人力工作,而ChatGPT仅需一个小时。 平均质量,拿出了这400个想法,向真实顾客做市场调研 “如果这个概念对您可用,您会基于它购买的可能性有多大?” MBA学生生成的想法的平均购买概率为40%,而GPT-4为47%, 以优秀想法为提示的GPT-4为49%。 杰出想法数量,在创新领域,杰出的想法才是最重要的。10%的杰出想法中, 只有5个是由学生生成的,而有35个是由 ChatGPT生成。 5

7 .与生成式AI协同创作 AI图像 Midjourney5.2 AI换脸 InsightFaceSwap AI视频 Pika labs和Runway Gen-2 AI编辑 PS Ai Beta 25.0和PromeAI AI音乐 Pixabay AI超分 Topazlabs …… 创作:上海交通大学文创学院 21级研究生 张勐 + AI tools 6

8 .生成式人工智能:科学含义 判别式模型 判别式人工智能 (almost out-of-shelf) 从给定数据中估计条件概率 P(Y|X) • SVM • CRF Jensen Huang • LDA • LR 分析 识别 • KNN • Boosting 估计数据分布 P(X) 创建新的数据 • GMM • GAN • HMM • VAE 重建 合成 • RBM • Flow 生成式模型 生成式人工智能 (next wave) 7

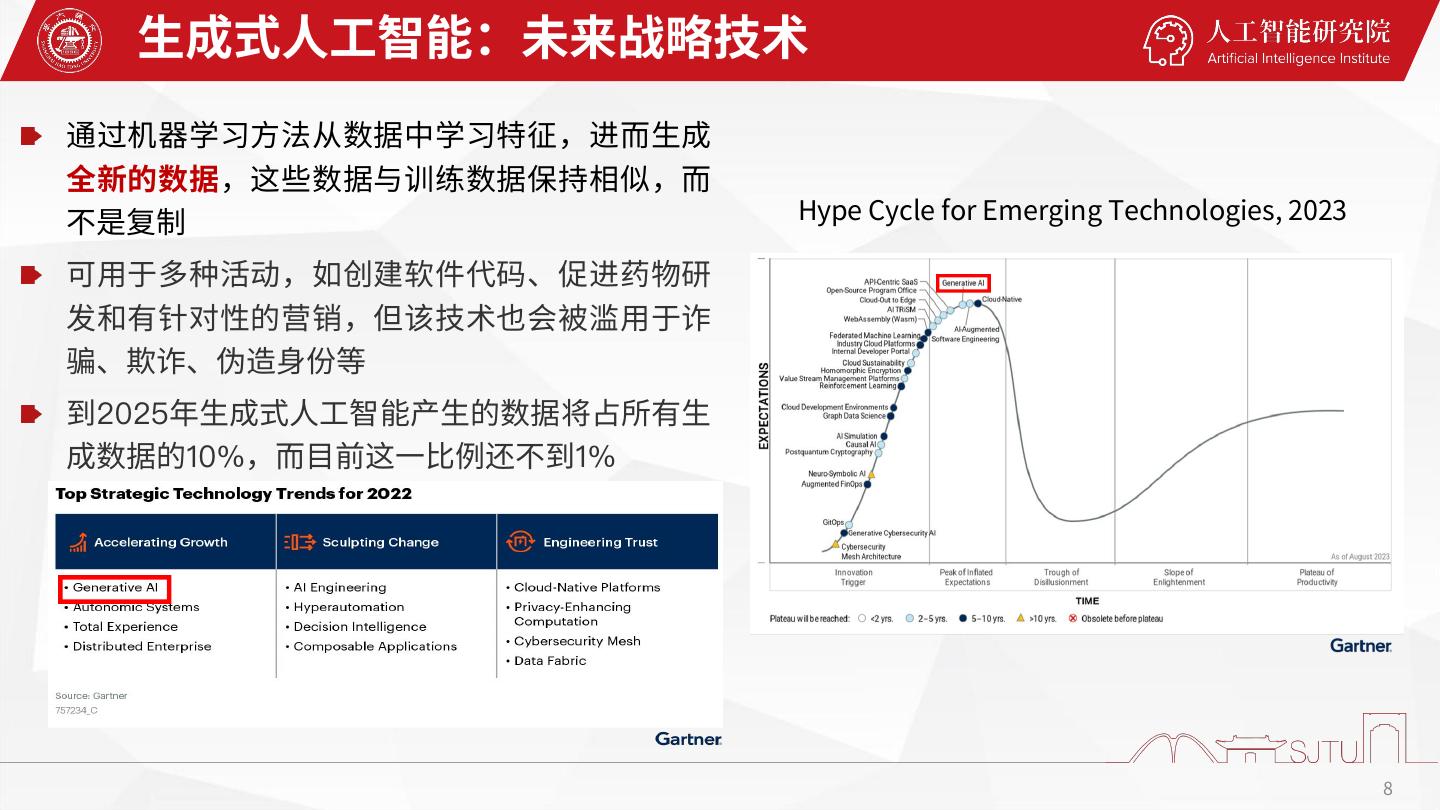

9 . 生成式人工智能:未来战略技术 通过机器学习方法从数据中学习特征,进而生成 全新的数据,这些数据与训练数据保持相似,而 不是复制 Hype Cycle for Emerging Technologies, 2023 可用于多种活动,如创建软件代码、促进药物研 发和有针对性的营销,但该技术也会被滥用于诈 骗、欺诈、伪造身份等 到2025年生成式人工智能产生的数据将占所有生 成数据的10%,而目前这一比例还不到1% 8

10 .生成式人工智能:产业影响 1.6%的运营成本降低 生成式人工智能将通过效率提升的方式在中国各产业带来 来源:罗兰贝格 9

11 .暴露:OpenAI的“时髦”概念 人工智能时代,什么工作更岌岌可危? OpenAI 引入了一个概念——暴露(Exposure) 它的衡量标准是,使用 ChatGPT 或相关工具,在保证质量的情况下,能否减少完成工作的时间。 “暴露”分为以下几个等级: E0:没有暴露 E1:直接暴露,仅使用大型语言模型(如 GPT-4),可以将时间至少减少 50% E2:间接暴露,单独使用大型语言模型无法达到效果,但在它的基础上开发的额外软件(如图像生 成),可以将时间至少减少 50% 10

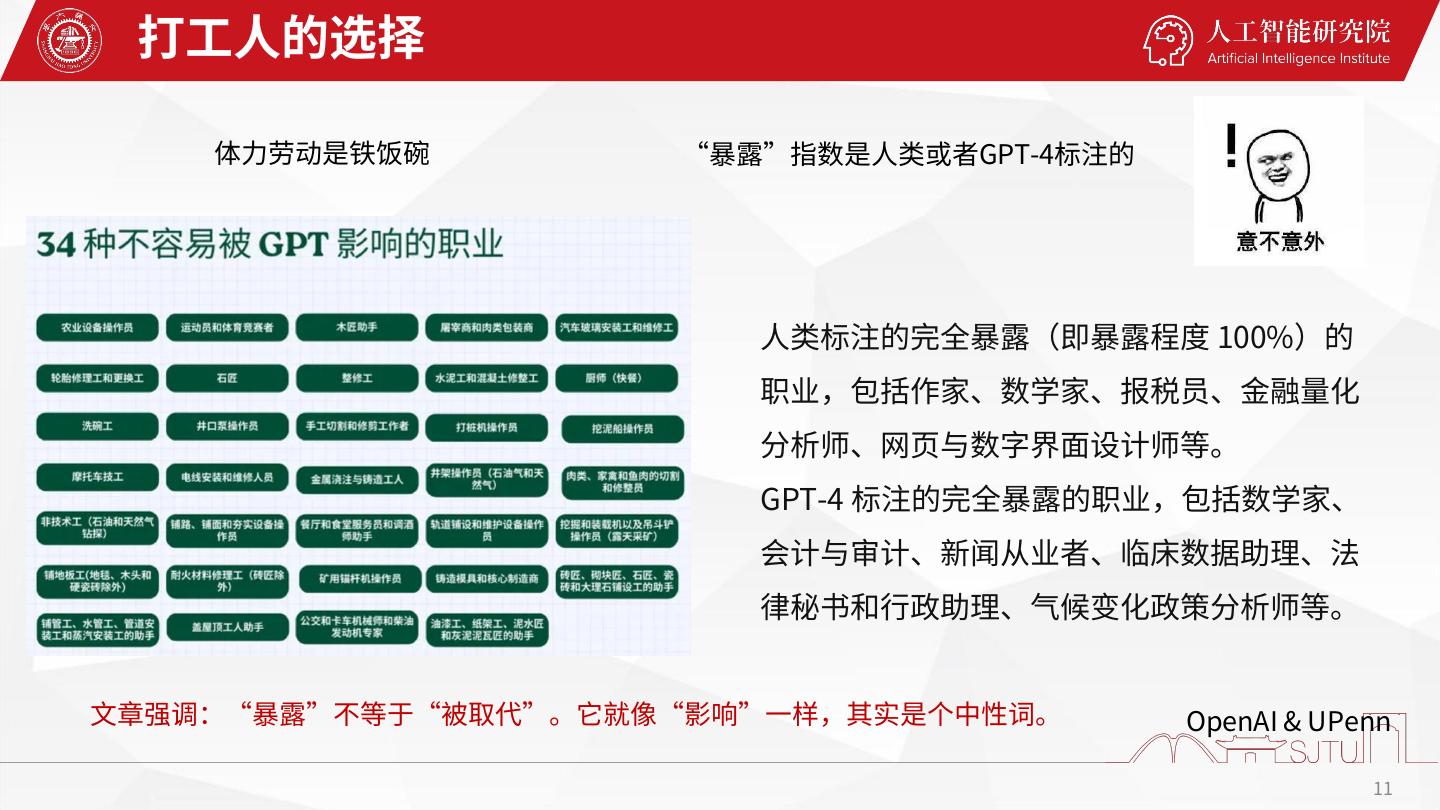

12 . 打工人的选择 体力劳动是铁饭碗 “暴露”指数是人类或者GPT-4标注的 人类标注的完全暴露(即暴露程度 100%)的 职业,包括作家、数学家、报税员、金融量化 分析师、网页与数字界面设计师等。 GPT-4 标注的完全暴露的职业,包括数学家、 会计与审计、新闻从业者、临床数据助理、法 律秘书和行政助理、气候变化政策分析师等。 文章强调:“暴露”不等于“被取代”。它就像“影响”一样,其实是个中性词。 OpenAI & UPenn 11

13 .中国的类似报告 城市数据团的研究:分析了1639种职业、19265条职能和23534种工作内容。 通过艰苦的学习实践来获取知识、积累经验的技能,人类已经落后于AI? 12

14 . 高盛:继续贩卖焦虑 生成式人工智能会导致劳动力市场出现“重大混乱”,使全球 3 亿个工作岗位实现自动化,并且美国 7% 的工作岗位将被 AI 取代! 美国约 2/3 的工作岗位会受到人工智能自动化的影响。而且,在受影响的岗位中,25%-50% 的工作可以被替换。 这份报告假设了,至少 50% 的重要且复杂的加权任务可能被 AI 所取代,而 10-49% 的工作更有可能得到 AI 的辅助,剩 下 0-9% 的工作不太可能受到影响。 63% 的工作岗位会得到 AI 的辅助,仅有 30% 的工作岗位没有受到 AI 的影响。 高盛援引一项研究发现,现在 60% 的劳动力所从事的职业,在 1940 年还不存在。这就意味过去 80 年,超过 85% 的职 业是由新技术驱动下所带来的。 13

15 . 生成式AI实际工作的案例研究 斯坦福大学数字经济实验室和麻省理工学院斯隆管理学院 研究了 5,179 名客户支持AI助手的数据,超过300万个对话, AI助手增加了客户支持人员的生产率,使每小时成功解决的客 户问题数量增加了13.8% AI助手对低技能和缺乏经验的员工影响最大。例如,最低技能 分位数的员工,每小时解决问题数量增加了35% 具有AI助手的员工两月内的表现就与无AI助手的员工六个月后 的表现一样好 AI助手改善了客户的情绪,减少了客户要求管理层干预的次数, 并降低了新员工的流失率 生成式AI在实际工作场所中的首个大规模使用实例,发现它提高了员工生产率,特别是低技能员工。 14

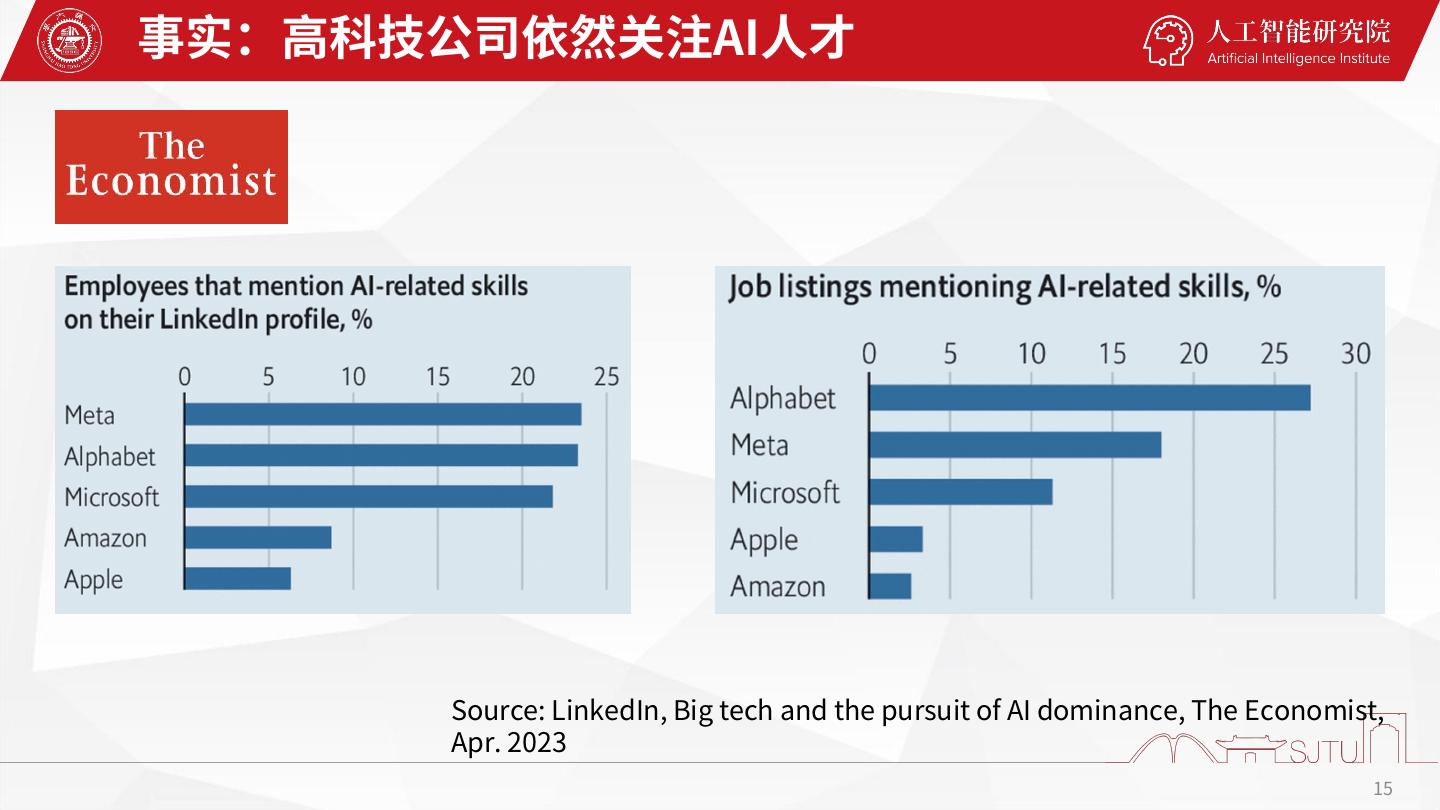

16 .事实:高科技公司依然关注AI人才 Source: LinkedIn, Big tech and the pursuit of AI dominance, The Economist, Apr. 2023 15

17 .chatGPT的问题 无法回答实时信息、私有问题 LLM知道它不知道什么,玩具 2020年5月28日,《中华人民共和国民 法典》表决通过,自2021年1月1日起 施行。 LLM不知道它知道什么,幻觉 16

18 .大语言模型的优与劣 优势 劣势 • 语言理解 • 实时知识 • 内容生成 • 私有数据 • 知识问答 • 幻觉现象 • 简单推理 • 复杂推理 • 代码理解 • 交互决策 • … • … 17

19 .增强大语言模型 白玉兰开源大模型:分子合成、司法、 客服、心理 …… 检索增强 微调对齐 智能代理 减少幻觉 领域适配 交互决策 18

20 . AI药物创新:白玉兰科学大模型 化合物大模型,实现变革性小分子创新设计、功能预测、化学反应预测; 多模态化学大语言模型,基础化学知识问答能力达到博士生水平,生成化学逆合成线路、 反应条件等,助力化学家高效合成变革性分子。 多模态科学数据 请帮我设计一个具备 某功能的可合成分子 化学教材 化学文献 请对如何优化分子 [xx] 分子结构数据 结构,使其具备某些功能 分子属性数据 化学反应数据 请帮我设计一个分子 [xx] 的逆合成线路和反应条件 化学实验数据 分子动力学仿真 请帮我预测一下化学反应 化学专家反馈 [A+B=C]在xx反应条件下 的产率和副产物 19

21 . 不要忘了生成式AI的风险 OpenAI麻烦不断 2022年11月,OpenAI和Github的代码助 2023年6月28日,16位匿名人士向OpenAI 2023年7月,美国联邦贸易委(FTC)给OpenAI列 手CoPolit被程序员们告上法庭,索赔达90 及微软发起诉讼,索赔30亿 了一个包括49个大问题,200多个小问题的清单, 亿美元。 OpenAI的chatGPT产品在没有告知或获得 要求OpenAI就清单上的所有问题进行详细地回答和 侵犯了众多原创代码作者的版权,同时还 本人同意的情况下,收集且泄露了他们的个 陈述。 泄露了用户隐私,因此向法院提起诉讼。 人信息。 20

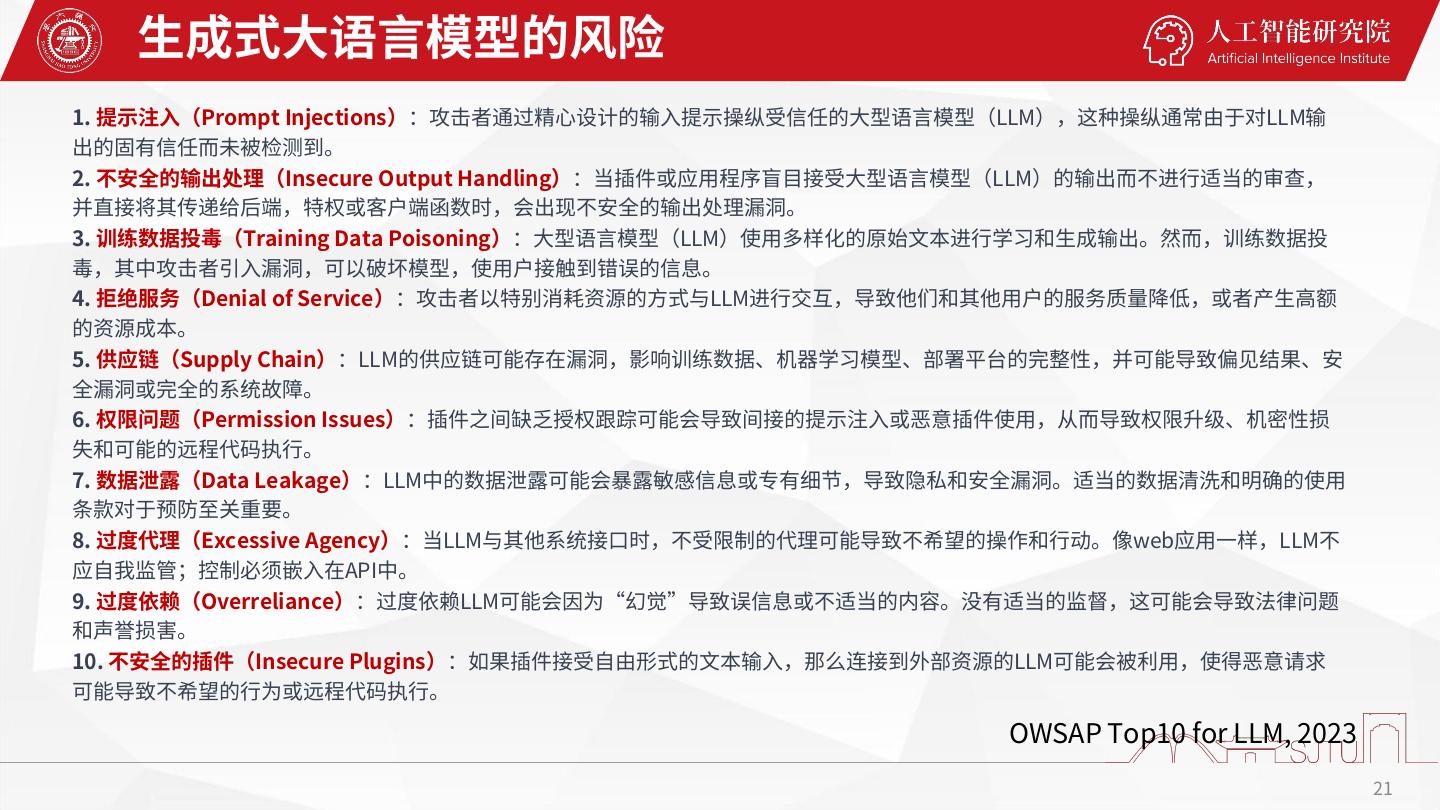

22 . 生成式大语言模型的风险 1. 提示注入(Prompt Injections):攻击者通过精心设计的输入提示操纵受信任的大型语言模型(LLM),这种操纵通常由于对LLM输 出的固有信任而未被检测到。 2. 不安全的输出处理(Insecure Output Handling):当插件或应用程序盲目接受大型语言模型(LLM)的输出而不进行适当的审查, 并直接将其传递给后端,特权或客户端函数时,会出现不安全的输出处理漏洞。 3. 训练数据投毒(Training Data Poisoning):大型语言模型(LLM)使用多样化的原始文本进行学习和生成输出。然而,训练数据投 毒,其中攻击者引入漏洞,可以破坏模型,使用户接触到错误的信息。 4. 拒绝服务(Denial of Service):攻击者以特别消耗资源的方式与LLM进行交互,导致他们和其他用户的服务质量降低,或者产生高额 的资源成本。 5. 供应链(Supply Chain):LLM的供应链可能存在漏洞,影响训练数据、机器学习模型、部署平台的完整性,并可能导致偏见结果、安 全漏洞或完全的系统故障。 6. 权限问题(Permission Issues):插件之间缺乏授权跟踪可能会导致间接的提示注入或恶意插件使用,从而导致权限升级、机密性损 失和可能的远程代码执行。 7. 数据泄露(Data Leakage):LLM中的数据泄露可能会暴露敏感信息或专有细节,导致隐私和安全漏洞。适当的数据清洗和明确的使用 条款对于预防至关重要。 8. 过度代理(Excessive Agency):当LLM与其他系统接口时,不受限制的代理可能导致不希望的操作和行动。像web应用一样,LLM不 应自我监管;控制必须嵌入在API中。 9. 过度依赖(Overreliance):过度依赖LLM可能会因为“幻觉”导致误信息或不适当的内容。没有适当的监督,这可能会导致法律问题 和声誉损害。 10. 不安全的插件(Insecure Plugins):如果插件接受自由形式的文本输入,那么连接到外部资源的LLM可能会被利用,使得恶意请求 可能导致不希望的行为或远程代码执行。 OWSAP Top10 for LLM, 2023 21

23 .中国发布《生成式人工智能服务管理暂行办法》 22

24 .生成式人工智能服务合规检查 合规模块 合规要求 责任主体 1.信息安全义务 提供者 2.内容合规 提供者、使用者 内容安全 3.生成违法内容的处理 提供者 4.用户管理 1.数据来源合规 数据安全 2.数据质量 提供者 3.数据标注规范 1.个人隐私与信息权益保护 2.合法性基础 个人信息保护 提供者 3.必要性、去标识、合法流通 4.响应用户行权 1.反歧视 提供者 科技伦理 2.保护个人权益 提供者、使用者 23

25 .生成式人工智能服务合规检查(续) 合规模块 合规要求 责任主体 1.尊重知识产权、商业道德,保守商业秘密 提供者、使用者 知识产权保护 2.模型训练不得侵犯知识产权 提供者 不得利用算法、数据、平台等优势,实施垄断 竞争法 提供者、使用者 和不正当竞争行为 1.透明度 2.服务协议 3.用户教育 产品合规 提供者 4.内容标识 5.服务连续性 6.投诉举报机制 1.安全评估 2.算法备案 监管手续 3.行政许可 提供者 4.外资准入 5.行业监管 24

26 . 风险与机遇 “当汽车出现的时候,受到了马车夫的集体抵制。因为马车夫担心自己会失业。但是实际上,汽 车的出现带来了汽车司机,维修工,生产工等各种更多的新职业,并且有更多的劳动力需要。” 25

27 . 为一个由AI驱动的生成世界做好准备 教育和技能发展:持续学习和提高技能对于个人在劳动力中保持相关性至关重要 行业转型:企业和组织必须紧跟人工智能的发展,探索如何利用生成性人工智能模型来优化他们的运 作,推动创新,并加强决策。 监管框架和道德:政府和政策制定者应努力为人工智能的发展和部署建立全面的监管框架和道德准则。 人工智能基础设施和投资:确保获得强大的人工智能基础设施,包括高速互联网、计算资源和先进算 法,对于发展和广泛采用生成性人工智能模型至关重要。 劳动力过渡支持:随着人工智能技术导致就业市场的转变,政府和组织必须为劳动力过渡提供支持, 以帮助个人适应人工智能驱动的世界中的新工作角色和机会。 公众意识和参与:提高公众对生成性人工智能的潜在利益和风险的认识,对于确保知情决策和促进关 于人工智能在社会中的作用的健康的公共讨论至关重要。 26

28 .谢谢