- 快召唤伙伴们来围观吧

- 微博 QQ QQ空间 贴吧

- 视频嵌入链接 文档嵌入链接

- 复制

- 微信扫一扫分享

- 已成功复制到剪贴板

《当AIGC模型变成一种服务》武卓/杨亦诚

《当AIGC模型变成一种服务》武卓/杨亦诚

展开查看详情

1 .当AIGC模型变成一种服务 武卓/杨亦诚 Intel

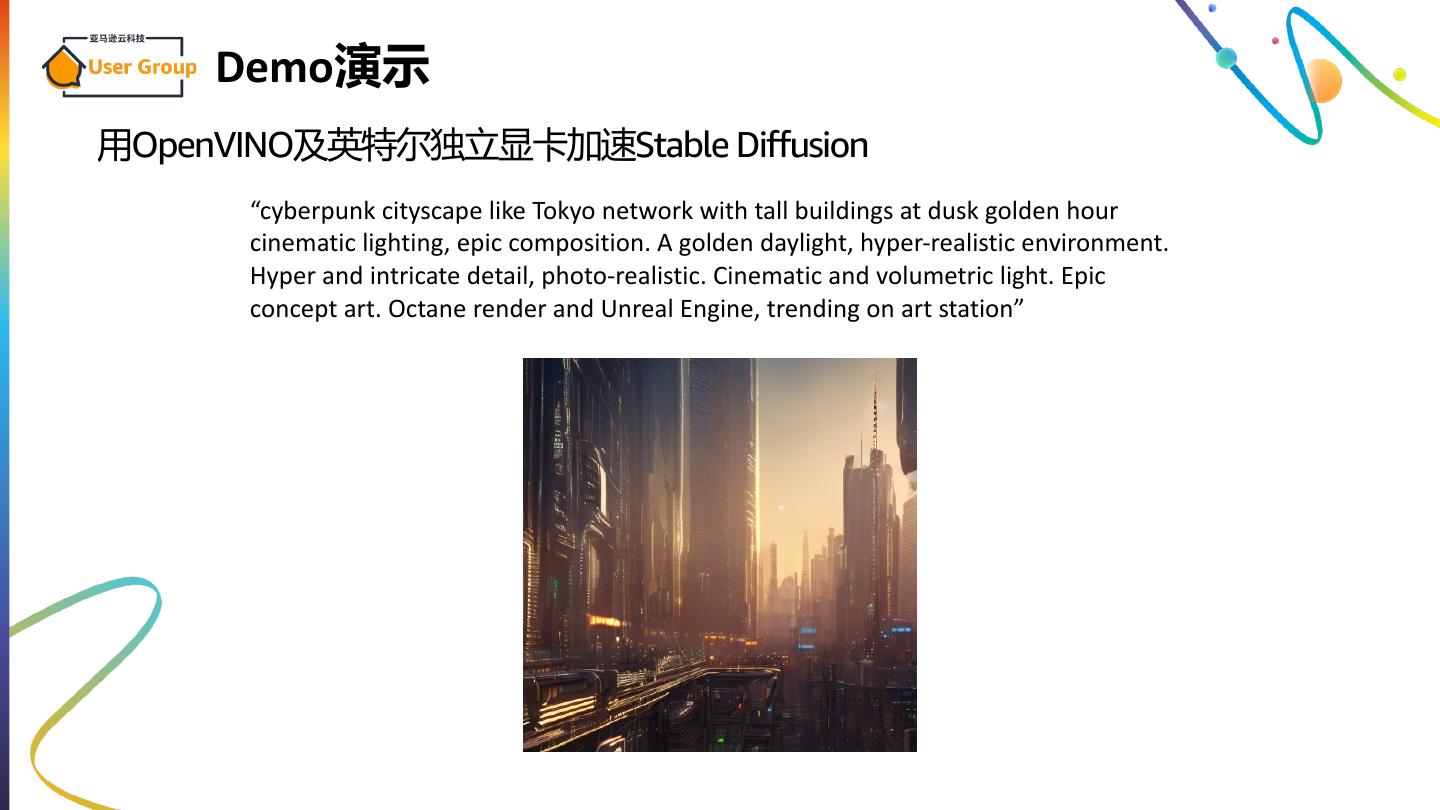

2 . Demo演示 用OpenVINO及英特尔独立显卡加速Stable Diffusion “cyberpunk cityscape like Tokyo network with tall buildings at dusk golden hour cinematic lighting, epic composition. A golden daylight, hyper-realistic environment. Hyper and intricate detail, photo-realistic. Cinematic and volumetric light. Epic concept art. Octane render and Unreal Engine, trending on art station”

3 .Why Intel® Distribution of OpenVINO™ Toolkit Fast, accurate real-world results with high-performance, deep learning inference 1 BUILD 2 Optimized Performance OPTIMIZE CPU GPU VPU FPGA 3 DEPLOY

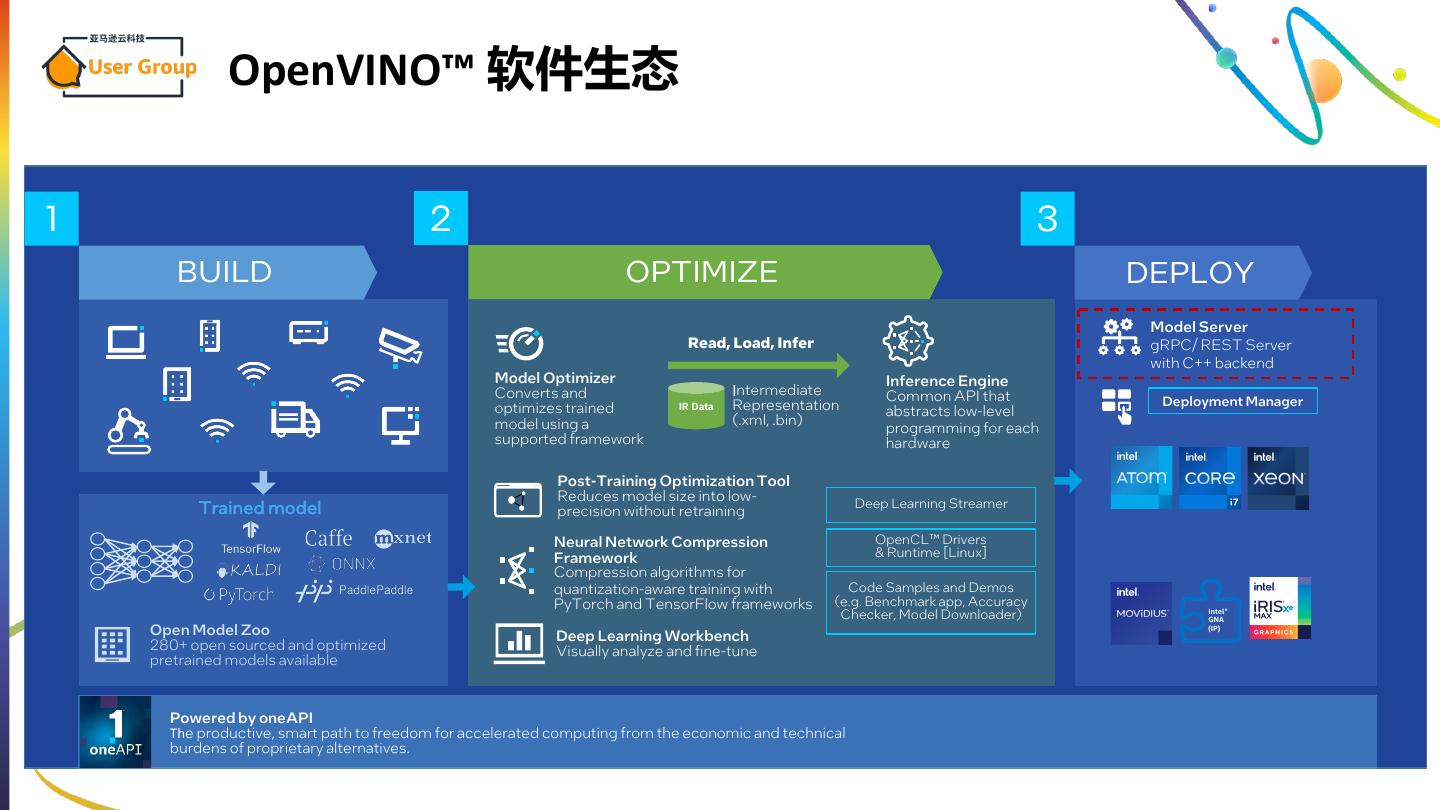

4 . OpenVINO™ 软件生态 1 2 3 BUILD OPTIMIZE DEPLOY Model Server Read, Load, Infer gRPC/ REST Server with C++ backend Model Optimizer Inference Engine Converts and Intermediate Common API that Representation Deployment Manager optimizes trained IR Data abstracts low-level model using a (.xml, .bin) programming for each supported framework hardware Post-Training Optimization Tool Reduces model size into low- Trained model Deep Learning Streamer precision without retraining Neural Network Compression OpenCL™ Drivers Framework & Runtime [Linux] Compression algorithms for quantization-aware training with Code Samples and Demos PyTorch and TensorFlow frameworks (e.g. Benchmark app, Accuracy Checker, Model Downloader) Intel® GNA Open Model Zoo Deep Learning Workbench (IP) 280+ open sourced and optimized Visually analyze and fine-tune pretrained models available Powered by oneAPI The productive, smart path to freedom for accelerated computing from the economic and technical burdens of proprietary alternatives.

5 .NCS2挑战

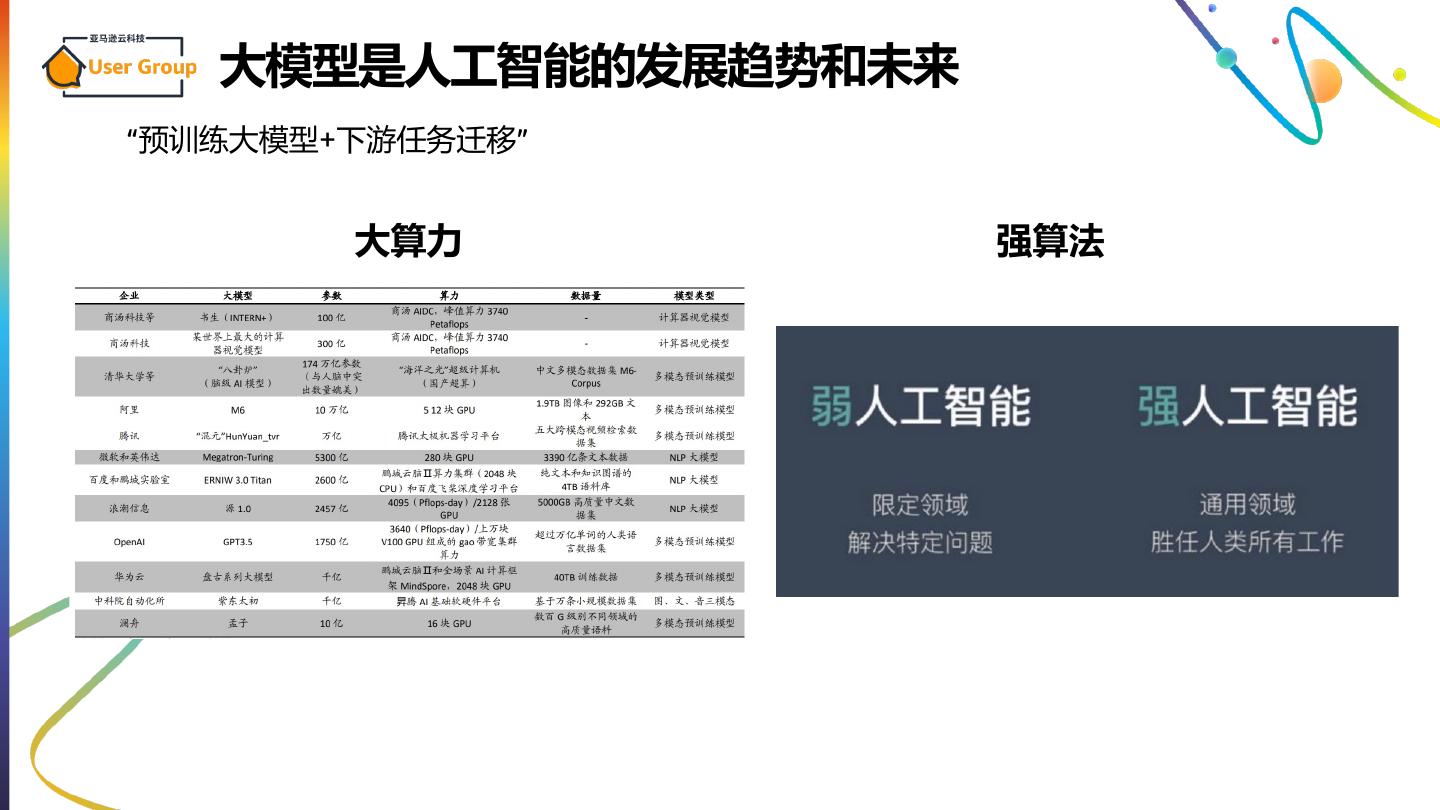

6 . 大模型是人工智能的发展趋势和未来 “预训练大模型+下游任务迁移” 大算力 强算法

7 .AIGC类大模型带来的技术挑战 算力 • GPT的参数量1.17亿 • GPT-3参数量直接暴涨至1750亿。 AI模型对算力的需求在过去短短几年内翻了大约100万倍,平均 每年十几倍,这个增速甚至超过了对算法精度增长的需求。 模型迭代 “在GPT-3之后,OpenAI的所有模型都没有开源,但它提供了 API调用,建立起了真实的用户调用和模型迭代之间的飞轮, 他非常重视真实世界数据的调用,以及这些数据对模型的迭代”

8 . 模型服务化(Model-as-a-Service) MaaS 将成为人工智能公司的核心商业模式

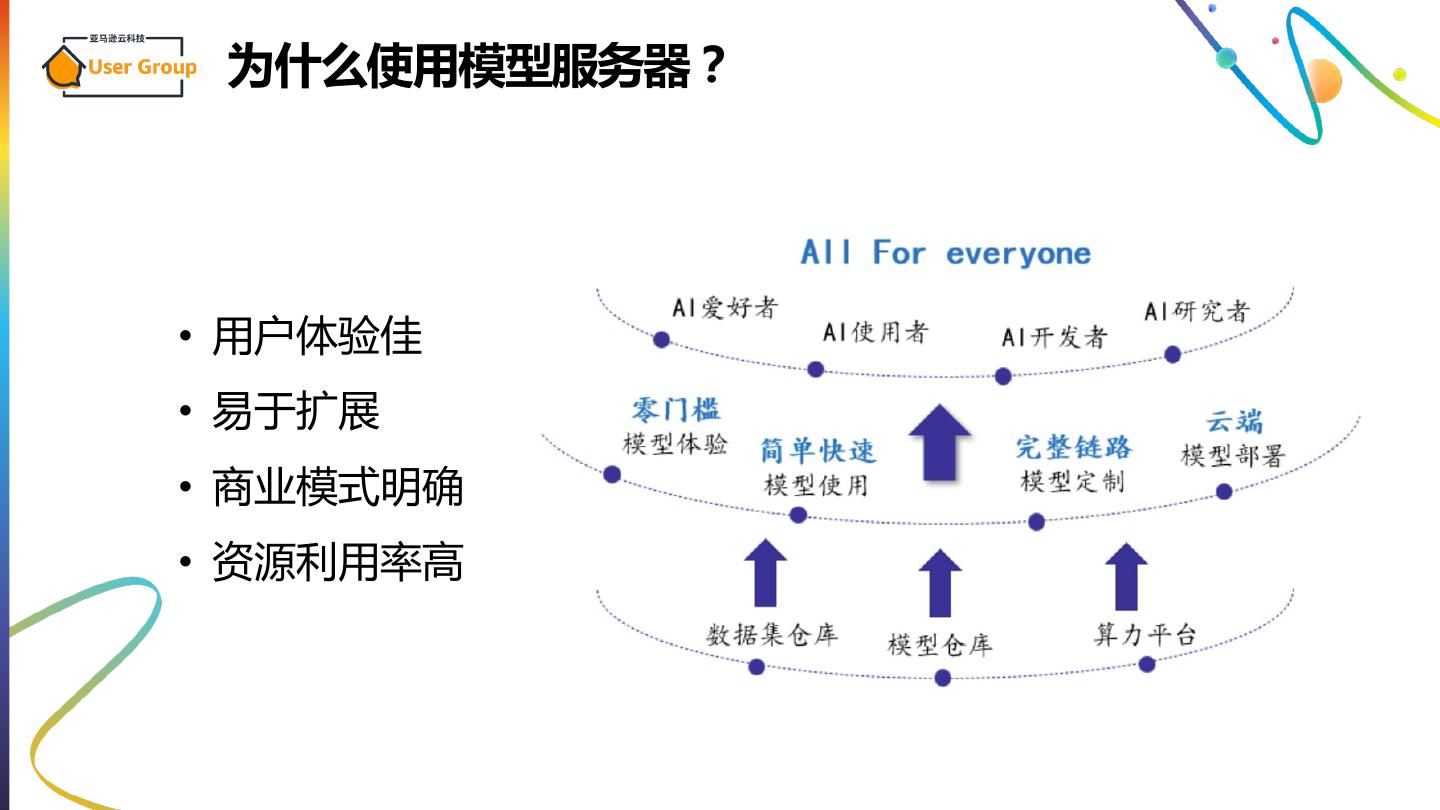

9 . 为什么使用模型服务器? • 用户体验佳 • 易于扩展 • 商业模式明确 • 资源利用率高

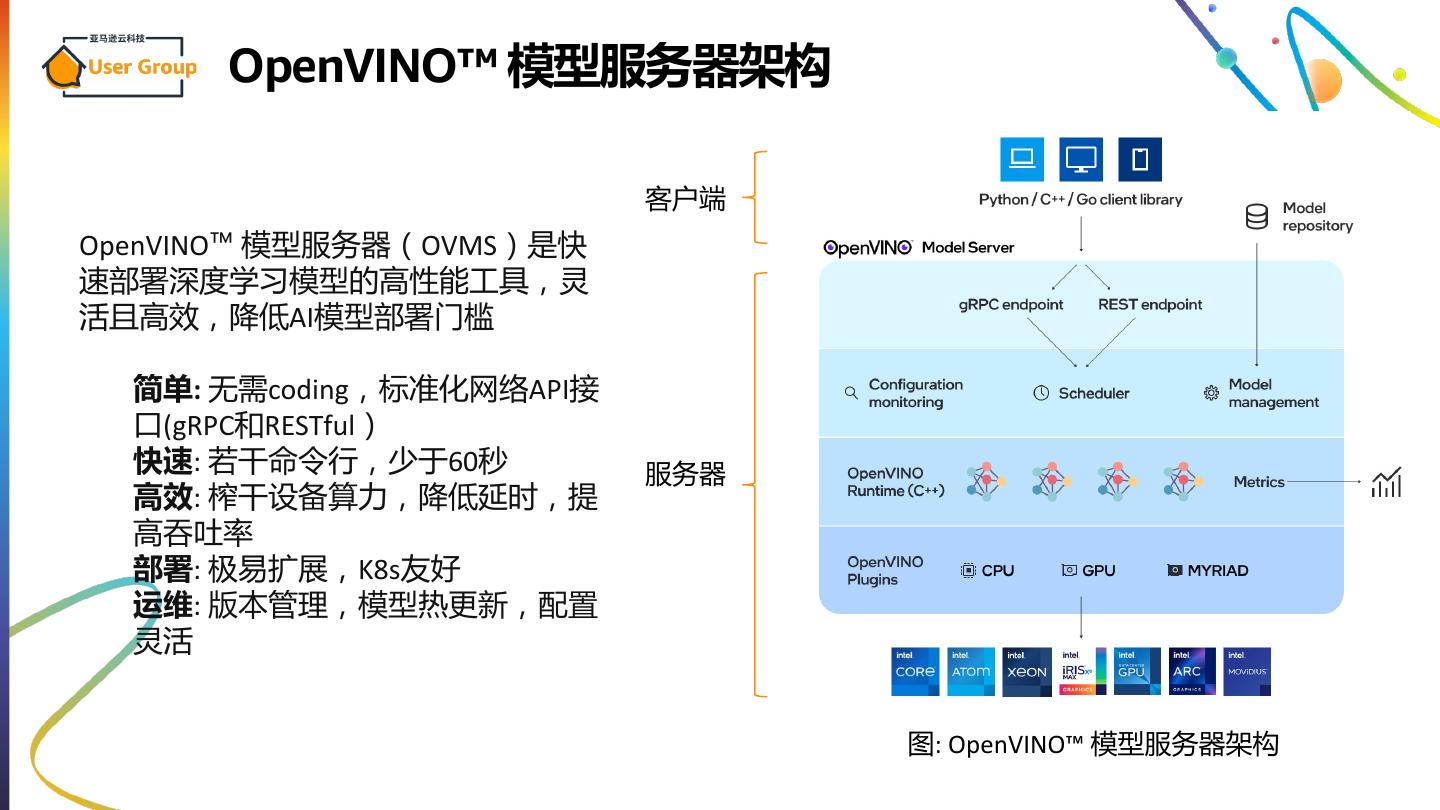

10 . OpenVINO™ 模型服务器架构 客户端 OpenVINO™ 模型服务器(OVMS)是快 速部署深度学习模型的高性能工具,灵 活且高效,降低AI模型部署门槛 简单: 无需coding,标准化网络API接 口(gRPC和RESTful) 快速: 若干命令行,少于60秒 服务器 高效: 榨干设备算力,降低延时,提 高吞吐率 部署: 极易扩展,K8s友好 运维: 版本管理,模型热更新,配置 灵活 图: OpenVINO™ 模型服务器架构

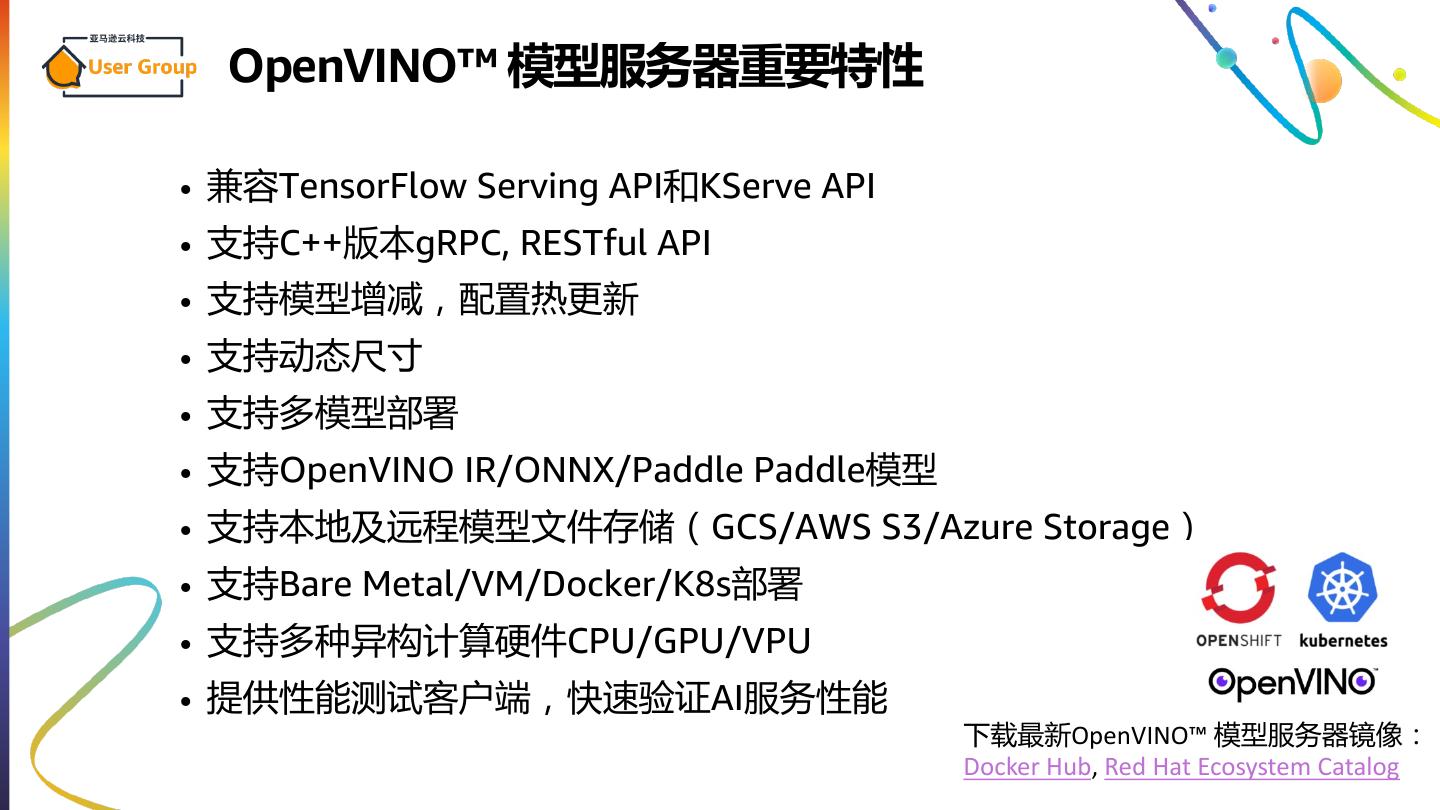

11 . OpenVINO™ 模型服务器重要特性 • 兼容TensorFlow Serving API和KServe API • 支持C++版本gRPC, RESTful API • 支持模型增减,配置热更新 • 支持动态尺寸 • 支持多模型部署 • 支持OpenVINO IR/ONNX/Paddle Paddle模型 • 支持本地及远程模型文件存储(GCS/AWS S3/Azure Storage) • 支持Bare Metal/VM/Docker/K8s部署 • 支持多种异构计算硬件CPU/GPU/VPU • 提供性能测试客户端,快速验证AI服务性能 下载最新OpenVINO™ 模型服务器镜像: Docker Hub, Red Hat Ecosystem Catalog

12 . OpenVINO™ 模型服务器演示 本例子演示了如何使用OpenVINO™ 模型服务器快速部署OCR AI应用, 用于图像中文字检测和识别。 1. 下载模型、测试视频和配置文件 git clone https://github.com/openvinotoolkit/model_server.git cd model_server/demos/horizontal_text_detection/python && make 2. 通过OVMS部署OCR流水线 docker run -p 9000:9000 -d -v ${PWD}/workspace:/workspace openvino/model_server --config_path /workspace/config.json --port 9000 3. 通过客户端向服务器发送请求 python3 horizontal_text_detection.py --grpc_address localhost -- grpc_port 9000 --use_case ocr

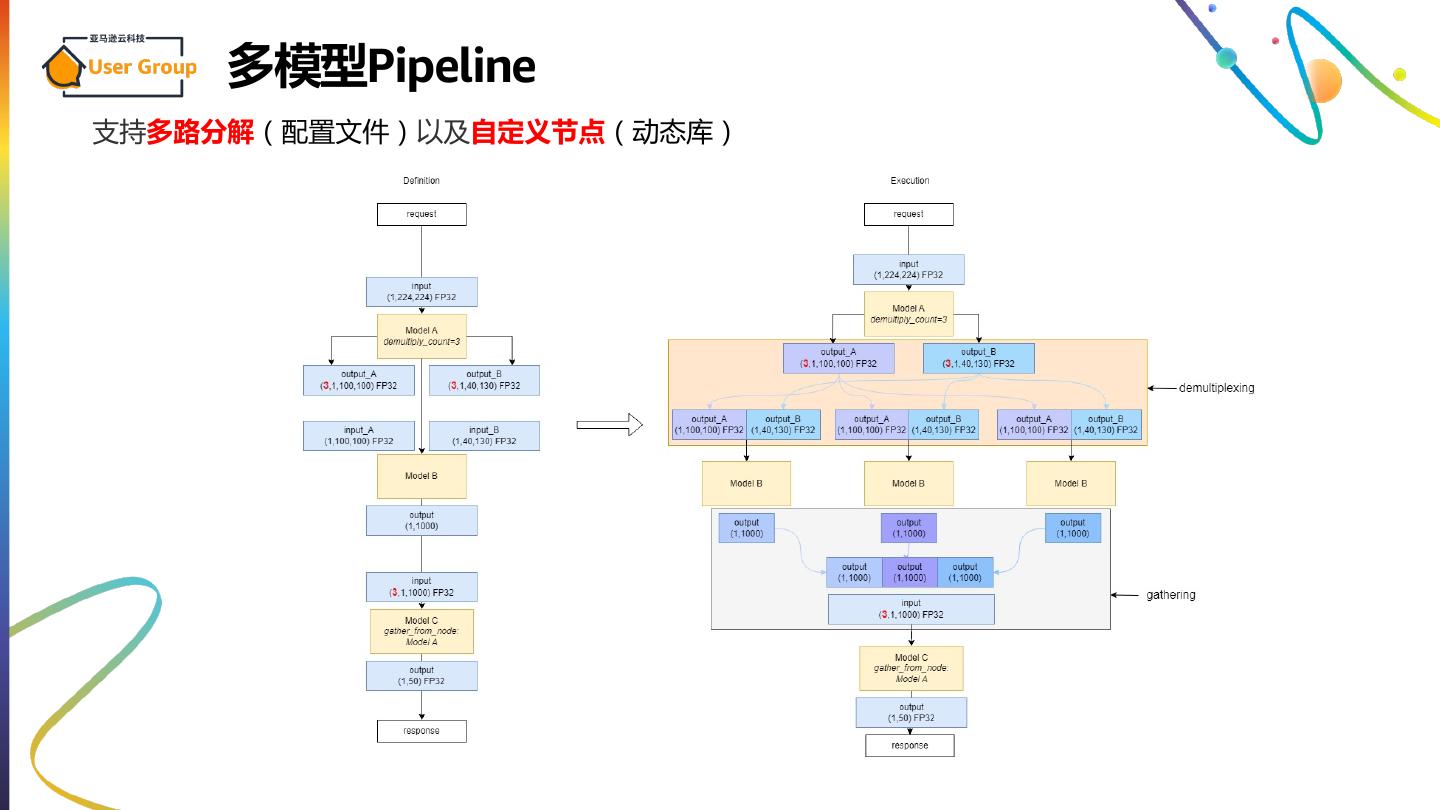

13 . 多模型Pipeline 支持多路分解(配置文件)以及自定义节点(动态库)

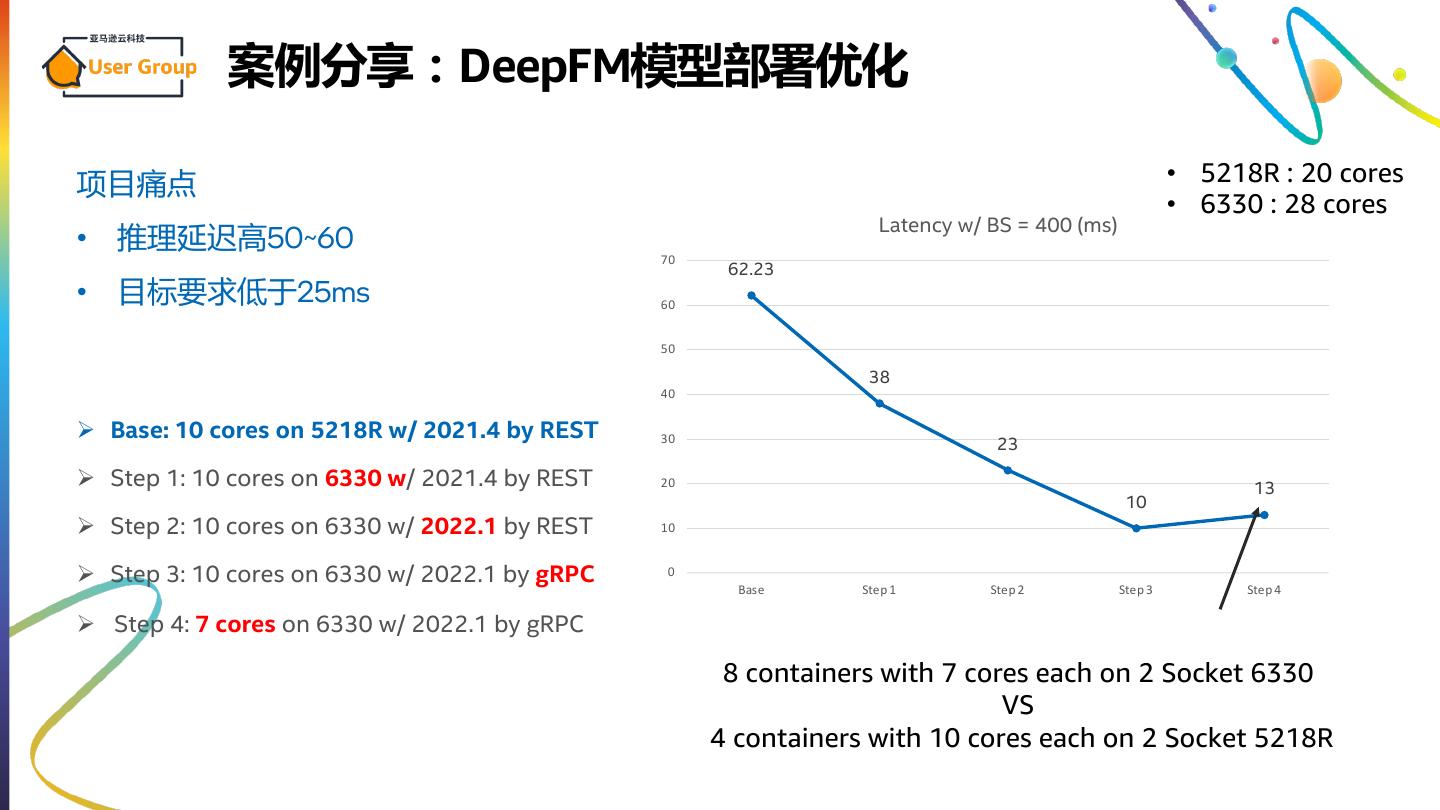

14 . 案例分享:DeepFM模型部署优化 项目痛点 • 5218R : 20 cores • 6330 : 28 cores Latency w/ BS = 400 (ms) • 推理延迟高50~60 70 62.23 • 目标要求低于25ms 60 50 38 40 Ø Base: 10 cores on 5218R w/ 2021.4 by REST 30 23 Ø Step 1: 10 cores on 6330 w/ 2021.4 by REST 20 13 10 Ø Step 2: 10 cores on 6330 w/ 2022.1 by REST 10 Ø Step 3: 10 cores on 6330 w/ 2022.1 by gRPC 0 Base Step 1 Step 2 Step 3 Step 4 Ø Step 4: 7 cores on 6330 w/ 2022.1 by gRPC 8 containers with 7 cores each on 2 Socket 6330 VS 4 containers with 10 cores each on 2 Socket 5218R

15 . 总结 • 大模型是人工智能的发展趋势和未来 • MaaS 将成为人工智能公司的核心商业模式 • OpenVINO™ 模型服务器可以实现简单、快速、高效地部署和运 维AI推理服务

16 . 更过OpenVINO与前沿技术资讯,截图保存本页! “OpenVINO开源代码贡献” OpenVINO 中文社区 下载OpenVINO 微信群 公众号