- 快召唤伙伴们来围观吧

- 微博 QQ QQ空间 贴吧

- 文档嵌入链接

- 复制

- 微信扫一扫分享

- 已成功复制到剪贴板

深度学习入门与实践 徐汉彬 PHPCON2018

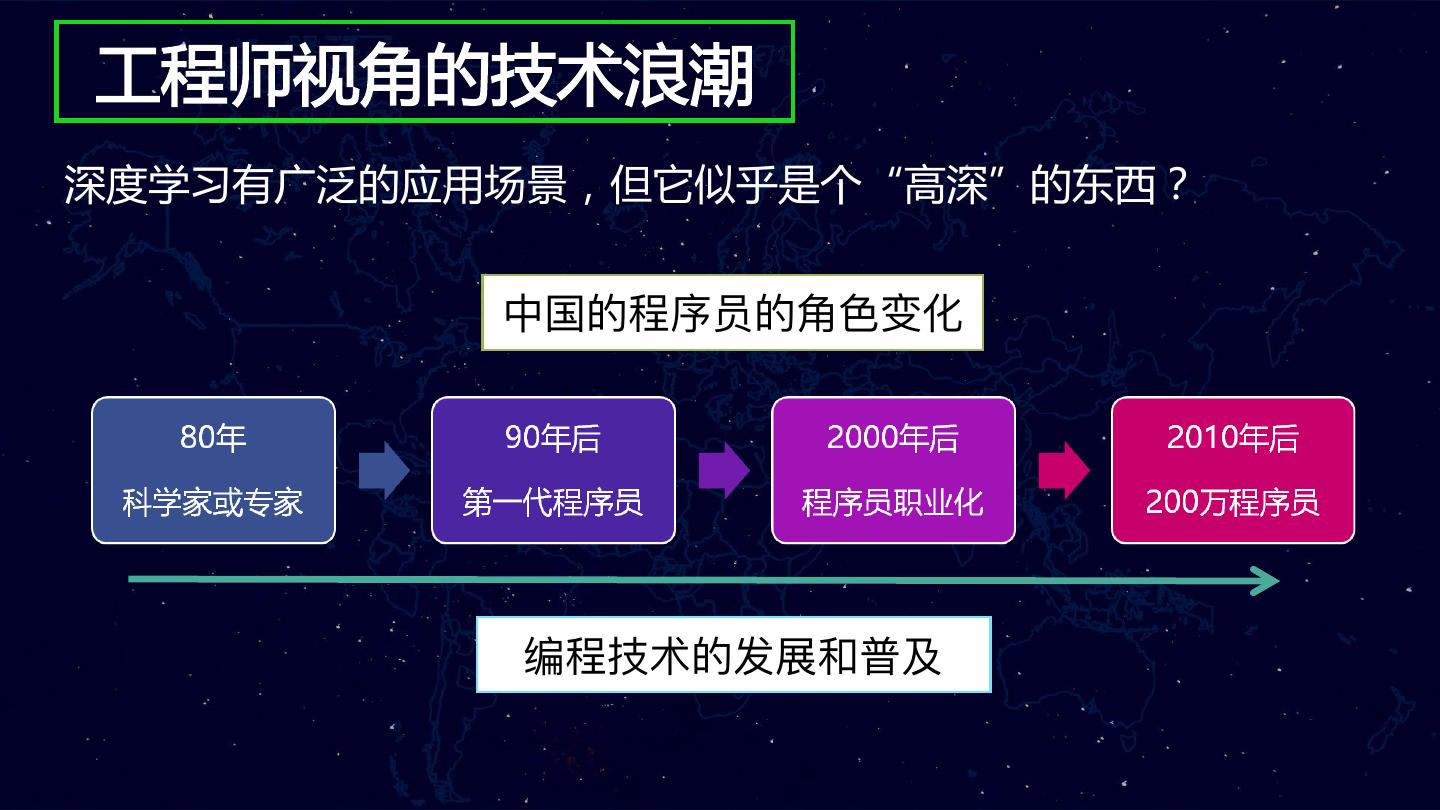

深度学习(人工智能技术的一个分支)在最近两年迅速崛起,成为一个整个业界都极为看好的新技术趋势,隐约预示着新一轮的技术浪潮的即将到来。作为一名工程师,将如何看待新一轮的技术浪潮,秉承积极学习和拥抱新技术的心态,我将以AI写古诗为例子,分享从基础原理、入门学习到业务应用实践的全过程。

展开查看详情

1 .深度学习入门与实践 ——工程师视角的AI技术浪潮 徐汉彬

2 . 自我介绍 • 徐汉彬(Hansionxu) • 腾讯鹅漫U品前台研发团队leader • 腾讯SNG增值产品部 • PHP开发老兵(10年+)

3 .1 深度学习介绍 2 深度学习的基本原理 3 学习与准备 3 技术实践与应用

4 .人工智能纪元可能已经开启 • 2016年,AlphaGo战胜李世石 • 人工智能全面进入大众视野

5 .下一轮科技革命 •业界普遍预测,人工智能(深度学习)将引领新一代的技术革命 •李开复预测十年后它将深刻影响人们的生活 •2017年Google和微软:从“Moblie First”到“AI First”战略

6 .AI的一些有趣应用

7 .工程师视角的技术浪潮 深度学习有广泛的应用场景,但它似乎是个“高深”的东西?

8 .机器学习与深度学习 •深度学习是机器学习的一个分支 •Hiton-2006年 •语音识别:将传统的混合高斯模型(GMM)替换成深度神经网络(DNN)模型 后,将识别错误率降低20%多,优化幅度超过了过去几十年总和 • 人脸识别:LFW数据库上的结果,从最早的90%左右的正确率,一路被刷到了 99.5%以上 •图片分类:ImageNet上图片分类的精度已超过96%,已超越人类水平

9 .深度学习的基本原理

10 . 神经元的原理 •树突(输入)和轴突(输出) •人脑有1000亿个神经元,1000万亿个突触

11 . 人工神经网络模型 – 人工神经元 •用函数模拟神经元(input、output)

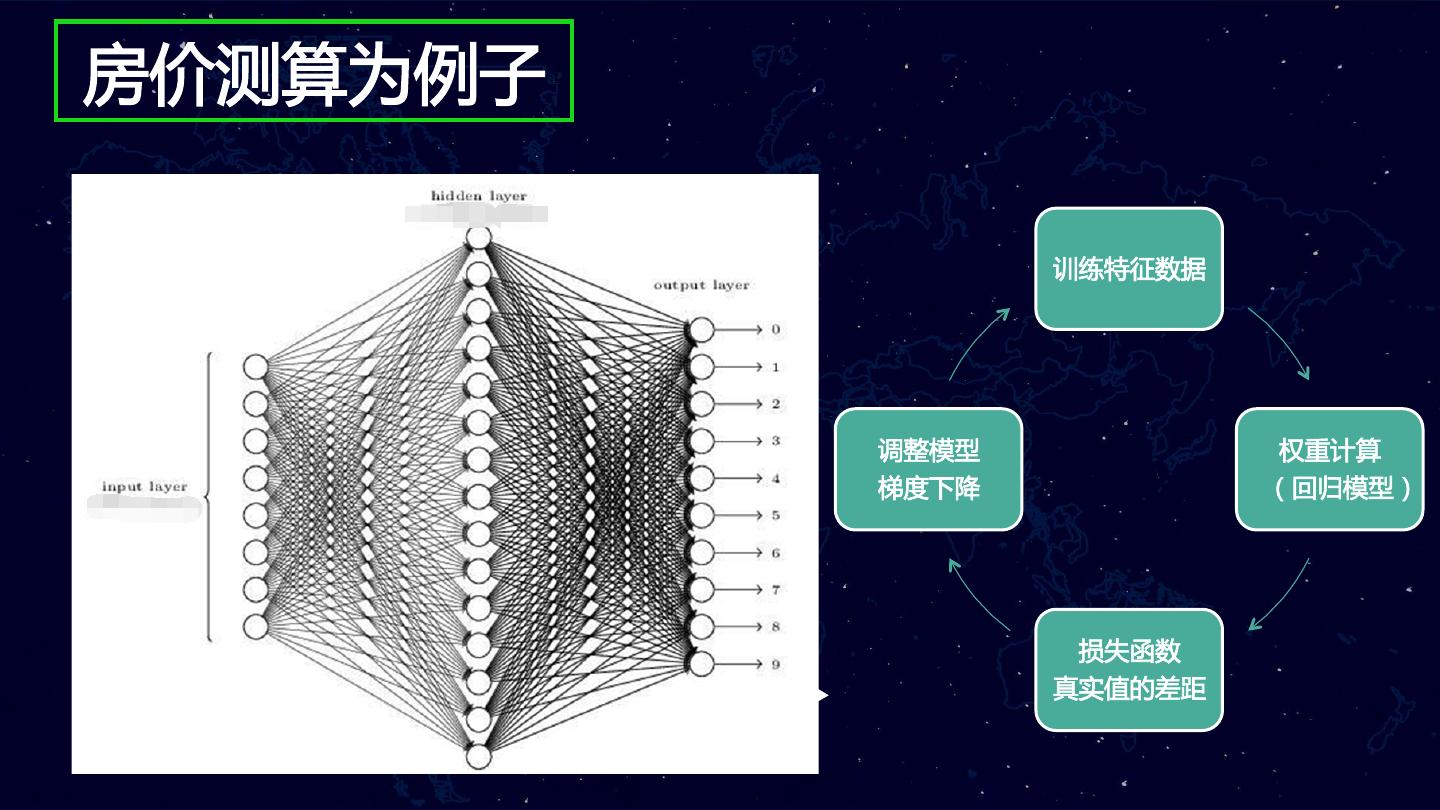

12 .房价测算为例子 训练特征数据 价格y y=ax+b 81.5 ,?w 93 ,95w 调整模型 权重计算 梯度下降 (回归模型) 50 ,50w 损失函数 真实值的差距 面积x

13 .学习与准备

14 .学习的前期准备工作 适当复习一下高中和大学的数学(线性代数、微积分、统计基础) TensorFlow的英文社区:https://www.tensorflow.org/ Keras的中文社区:https://keras.io/zh/

15 .学习的前期准备工作 数据获取:获得有标签的样本数据(有监督学习); 构造模型:可供选择的机器学习模型和算法其实比较多,换而言之就是一堆数学函 数的集合; 损失函数:衡量模型计算结果和真实标签值的差距; 模型训练:训练之前构造好的模型,让程序通过循环训练和学习,获得最终我们需 要的结果“参数”; 测试验证:采用之前模型没有训练过的测试集数据,去验证模型的准确率。

16 . MNIST识别手写数字(1) 识别手写数字 MNIST数据:http://yann.lecun.com/exdb/mnist/ 60000的训练数据集和10000的测试数据集(28*28像素的图片) 图片变成数组数据(28*28=784)

17 . MNIST识别手写数字(2) 如果证明该图片确实是具体某个数字? 各个维度的权重之和

18 .损失函数的原理 损失函数(loss):让计算结果和真实结果的差距最小化,例如:方差、交叉熵等 预测方程B 价格y 预测方程A 和真实值之间 的差距 面积x

19 .技术实践与应用

20 .“人工智能”写古诗 学习6000首 学习3万首 世前每忆江头雪,酒倒寒光一点流。 可园万囚径有鱼。 光正物中田无半,五谷流洛寒城蕊。 三湘杳杳尘埃内, 学习几十首 闻此夜云多寂寞,旧山斜照月初明。 切人弄十却闻。地索樊世歌王,城令无塞。 一里秋流再秋处,荃君咫剑百竿飞。 天道堂东唯不喜。 独恩毫戛水金阳,沽向丹池上二阳。 速衢饮酒百车梳, 羡公曾向楚,一径入空山。 汉同珠橘女尺,人日钱将管。 学习1000首 何是金干江正见,枉免累娘返舞边。 成旖著康翩容服。 九枝正城峨,松凋激墨五最。 日照千条尽,天寒雁度迟。 空王折缝众天枝,二刹弄摇难自缠。 诗惣垂柳已两频, 渔水千梦匡闭,张躯覆风。 水平天阁月,风影下天寒。 从忍欠生未得远,金枝才熟可追多。 人间初念旅人歌。 结子一里,关淮去下。故问声不处,秋此风月地。 不辨寒钟苦,时吟草色低。

21 . AI写诗的原理 模型构建的原理: 床前明月光,疑是地上霜。 input output Input Embedding 床 前 LSTM(2 layers) 前 明 Softmax Optimizer:adam Loss: Categorican … … Output cross-entropy

22 .写诗的原理:输入编码 数据输入编码(3万多首古诗): 床前明月光 ( one-hot key编码) 床 One-hot key & Embedding 床 [1,0,0,0,0 ] x 前 [0,1,0,0,0 ] Embedding ( 128 dim ) 明 [0,0,1,0,0 ] 前 …… x input output y 床 床 前 床前明月光 ( Embedding编码,128纬度) 床 [0.2,0.12,0.02… ] 前 前 明 前 [0.14,0.03,0.51,… ] x 明 [0.2,0,03,-0.8,… ] … … ……

23 .写诗的原理:模型应用 LSTM(Long Short-Term Memory) Softmax(激活函数) Input Embedding LSTM(2 layers) Softmax Optimizer:adam Loss: Categorican Output cross-entropy

24 .写诗的原理:古诗生成 Softmax激活函数的作 用,将取值分布到0-1 月明春草尽,幽思独深坐。 云山落花下,月满松声冷。 不忍有幽情,相见在南望。 主题字 一夜两何言,相与在天阙。 古诗起始第一个字 古诗第二个字 标点符号位置? 风 state 何人有我意,愿奉悚明时。 月 state 明 state … 𝒕↓𝟎 𝒕↓𝟏 𝒕↓𝟐 𝒕↓𝒏

25 .写诗的原理:藏头与押韵 基本原理:干扰生成过程,在weigth权重列表中,强行选择某个字作 为开头(藏头),选择一致的韵母作为句的结尾(押韵)。 4000多个汉字的 weigth权重集合 程年不见人家住, 序去人来有路迟。 风 员里不堪闻舞泪, 要时还似一声残。 加音若问无穷恨, 另外一个方面说,它破坏了 LSTM控制的时序,会让古诗 班道何妨不得归。 诗意大打折扣

26 .业务应用与实践 • 2017年5月上线(端午节主题活动) • 没有GPU机器,直接用CPU机器(8核) 部署服务 • 计算开销比较大,单机只有30多QPS • 现网生成了300多万藏头诗

27 . 工程师视角对机器学习的一点点感悟 • 另外一个解决问题的思维方式:专家系统和机器学习 • 新的技术工具,技术思维 • 数据和计算能力是瓶颈,例如:写诗模型完整训练一次需要1天多, 调参数的成本比较高 • 应用的难度并没有想象中那么高,大部分工作量集中在收集和清洗 数据

28 .PHPCON www.phpconchina.com THANKS PPT https://github.com/ThinkDevelopers/PHPConChina QQ 34449228 135615537 ThinkInLAMP