- 快召唤伙伴们来围观吧

- 微博 QQ QQ空间 贴吧

- 文档嵌入链接

- 复制

- 微信扫一扫分享

- 已成功复制到剪贴板

离散信息源及其信息测度

展开查看详情

1 .信息论与编码技术 第 2 章 离散信源及其信息测度 苗付友 mfy@ustc.edu.cn 2018 年 9 月

2 .2.1 信源的数学模型及分类 2.2 离散信源的信息熵 2.3 信息熵的基本性质 和定理 2.4 离散无记忆的扩展信源 2.5 离散平稳信源 2.6 马尔可夫信源 2.7 信源剩余度与自然语言的熵 本章内容

3 .信源 消息或消息序列 包含信息 关注信源的各种 可能的输出 以及输出各消息的 不确定性 信源描述:概率空间(样本空间 + 概率测度) 随机变量描述消息 随机矢量描述消息 随机过程描述消息 2.1 信源的数学模型及分类

4 .1 )一维离散信源 适用场景:信源可能输出的 消息数 是 有限或可数 的,且 每次只输出一个消息 。 例子:扔一颗质地均匀的骰子,研究下落后朝上一面的点数。 特点: 1. 每次实验只出现一个点数(消息); 2. 每个点数的出现是随机的; 3. 点数必定为 1,2,3,4,5,6 中的某一个; 因此:符号集 A : {a 1 , a 2 , a 3 , a 4 , a 5 , a 6 } 表示基本消息集合;离散型随机变量 X 描述信源输出的消息,其样本空间为 A; X 的概率分布即为各消息出现的先验概率 : P(X= a 1 )=P(X= a 2 )=…P(X= a 6 )=1/6. 2.1.1 随机变量描述信源消息

5 .2.1.1 随机变量描述信源消息 因此,该信源的数学模型为:

6 .该类信源特点: 输出都是单个符号的消息,符号集取值有限或可数 一维离散型随机变量 X 描述,即离散信源。 数学模型:单符号离散型概率空间 2.1.1 随机变量描述信源消息 X — 随机变量,指的是信源整体 x i — 随机事件的某一结果或信源的某个元素(消息) p ( x i ) = P ( X = x i ) — 随机事件 X 发生某一结果 x i 的概率。 n 是有限正整数或可数无限大

7 .2 )一维连续信源 连续信源:如语音信号某时间的连续取值数据 一维连续型随机变量 X 描述 数学模型为连续型概率空间 2.1.1 随机变量描述信源消息 满足 R 为实数集 ,p(x) 为连续型随机变量的 X 的密度函数,概率空间满足完备性。

8 .适用场景: 信源输出的消息由一系列符号序列组成,其中每个符号的出现是不确定的、随机的。 例子: 中文自然语言 作为 信源 : 中文信源的 样本空间 A 为 所有汉字和标点符号的集合 。汉字和标点符号构成的 序列 即为 中文句子和文章 (即消息) 。注意:每个汉字和标点符号的出现时随机、不确定的。 特点: 信源输出的消息为按一定概率选取的符号序列,时间或空间上离散的一系列随机变量(随机矢量) 2.1.2 随机矢量描述信源消息

9 .消息的描述: N 维随机矢量 X=(X 1 X 2 …X N ), N 为有限正整数或可数的无限值 , X i 为离散随机变量。 离散平稳信源 : 信源输出随机矢量 X=(X 1 X 2 …X N ), 其中的每个离散型随机变量 X i 在任意两个不同的时刻分布相同。即 X 的各维概率分布都 与时间起点无关 -- 任意两个不同的时刻随机矢量 X 的各维概率分布相同。 连续平稳信源 信源输出消息可用 N 维随机矢量 X=(X 1 X 2 …X N ), 描述,每个随机分量取值为连续的连续型随机变量,且 X 的各维概率密度函数与时间起点无关。 2.1.2 随机矢量描述信源消息

10 .平稳信源: 无记忆信源,有记忆信源 离散无记忆信源 信源输出的随机矢量 X =(X 1 X 2 …X N ) 中,各个离散型随机变量 X i 之间的无依赖、统计独立的。即 P( X )=P(X 1 X 2 …X N ) =P 1 (X 1 ) P 2 (X 2 )… P N (X N )= (因为是平稳信源,即 P 1 (X 1 )= P 2 (X 2 )=… =P N (X N ) 。) 如果各个离散随机变量 X i 取值于同一符号集 A : {a 1 ,a 2 ,… a q } 为 N 维随机矢量一个取值, 为符号集 A 的一维概率分布 2.1.2 随机矢量描述信源消息

11 .符号集 A 与概率测度 构成一个概率空间 由信源空间 [X,P(x)] 描述的 信源 X 为 离散无记忆信源 。 特点:信源不同时刻发出符号之间 无依赖、彼此统计独立 。 信源 X 所输出的随机 矢量所 描述的 信源 X N 为 离散无记忆信源 X 的 N 次扩展信源 2.1.2 随机矢量描述信源消息

12 .2.1.2 随机矢量描述信源消息 离散无记忆信源 X 的 N 次扩展信源的数学模型 是 X 信源空间的 N 重空间

13 .离散有记忆信源 信源输出的平稳离散随机序列 X 中,各随机变量 X i 间是相互依赖的。 例如:汉字组成的中文语句,其中各个汉字相互依赖 2.1.2 随机矢量描述信源消息

14 .m 马尔科夫信源 记忆长度为 m+1 的信源,即信源每次发出的符号只与前面 m 个符号有关,与更前面的符号无关。 假设为 X =X 1 X 2 …X i-1 X i X i+1 …X N , i 时刻的随机变量 X i 取什么符号只与前 m 个随机变量 X i-1 X i-2 …X i-m 的取值有关。设各时刻随机变量 X k 的取值为 , 则随机序列中各随机变量之间的依赖关系为: 如果上述条件概率与时间起点 i 无关,则输出符号序列为 时齐马尔科夫链, 信源即为 时齐马尔科夫信源。 2.1.2 随机矢量描述信源消息

15 .连续平稳信源 连续平稳有记忆信源 连续平稳无记忆信源 2.1.2 随机矢量描述信源消息

16 .随机波形信源 信源输出的消息是时间(或空间)上和取值上都是连续的 用随机过程 {x(t)} 描述 2.1.3 随机过程描述信源消息

17 .2.1 信源的数学模型及分类

18 .2.2.1 自信息 2.2.2 信息熵 2.2 离散信源的信息熵

19 .单符号离散信源 2.2.1 自信息 1. 该信源能输出多少信息? 2. 每个消息的出现携带多少信息量?

20 .信息量与不确定性 信源中某一消息发生的不确定性越大,一旦它发生,并为收信者收到后,消除的不确定性就越大,获得的信息也就越大。 由于种种原因(例如噪声太大),收信者接收到受干扰的消息后,对某信息发生的不确定性依然存在或者一点也未消除时,则收信者获得较少的信息或者说一点也没有获得信息。 2.2.1 自信息

21 .信息量的大小与不确定性消除的多少有关 无噪声信道 有噪声信道 不确定性多少与事件发生的概率相关 2.2.1 自信息

22 .2.2.1 自信息

23 .2.2.1 离散变量的自信息量 信息量与不确定性 信息量的直观定义: 收到某消息获得的 信息量 =不确定性减少的量 = ( 收到此消息 前 关于某事件发生的不确定性 ) - ( 收到此消息 后 关于某事件发生的不确定性 )

24 .2.2.1 离散变量的自信息量 信息量与不确定性 信息量的直观定义: 在无噪声时,通过信道的传输,可以完全不失真地收到所发的消息,收到此消息后关于某事件发生的不确定性完全消除,此项为零。因此: 收到某消息获得的 信息量 =收到此消息 前 关于某事件发生的不确定性 =信源输出的某消息中所含有的 信息量

25 .2.2.1 离散变量的自信息量 不确定性与发生概率 事件发生的概率越小,我们猜测它有没有发生的困难程度就越大,不确定性就越大。 事件发生的概率越大,我们猜测这件事发生的可能性就越大,不确定性就越小。 概率等于 1 的必然事件,就不存在不确定性。 某事件发生所含有的信息量应该是该事件发生的 先验概率 的函数。

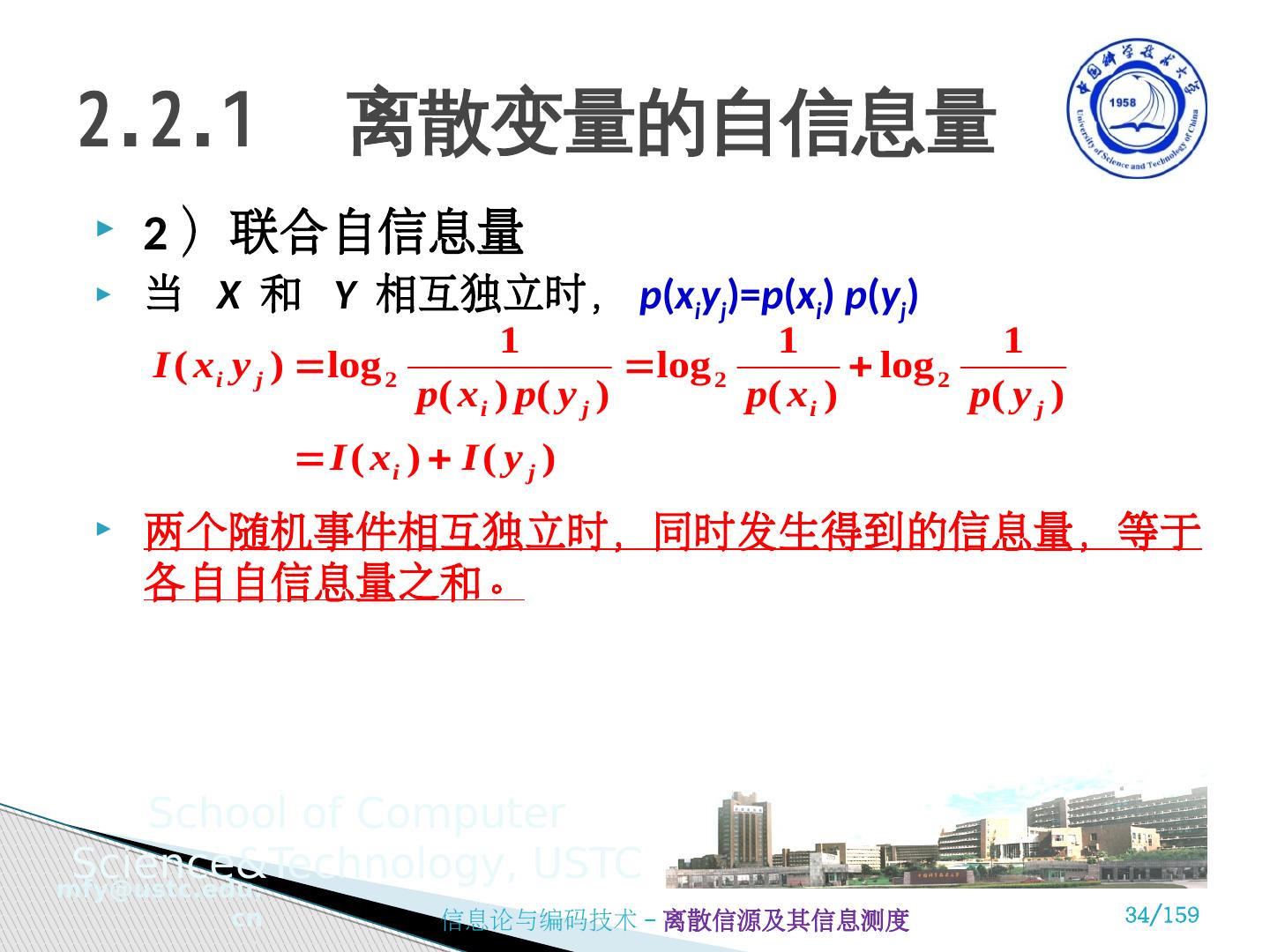

26 .2.2.1 离散变量的自信息量 不确定性与发生概率 函数 f [ p ( x i )] 应满足以下 4 个条件: f [ p ( x i )] 应是 p ( x i ) 的单调递减函数 当 p ( x 1 )> p ( x 2 ) 时, f [ p ( x 1 )]< f [ p ( x 2 )] 当 p ( x i ) =1 时, f [ p ( x i )] =0 当 p ( x i ) =0 时, f [ p ( x i )] =∞ 两个 独立事件 的联合信息量应等于它们分别的信息量之和。即 统计独立信源 的信息量等于它们分别的信息量之和。

27 .2.2.1 离散变量的自信息量 不确定性与发生概率 根据上述条件可以从数学上证明这种函数形式是对数形式。

28 .不确定性与发生概率 用概率测度定义信息量: 设离散信源 X ,其概率空间为: 如果知道事件 x i 已发生,则该事件所含有的自信息定义为: X , Y , Z 代表随机变量,指的是信源整体; x i , y j , z k 代表随机事件的某一结果或信源的某个元素。 不可混淆 ! 2.2.1 离散变量的自信息量

29 .当事件 发生以前,表示事件 发生的不确定性; 当事件 发生以后,表示事件 所含有 ( 提供 ) 的信息量; 自信息单位: 2.2.1 离散变量的自信息量 1 奈特 =log 2 e=1.443 比特 1 哈特 =log 2 10=3.322 比特